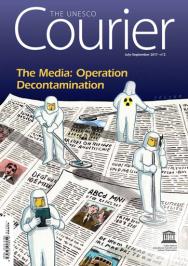

مقال

مواجهة بين أفتنبوستن و فيسبوك : الجدال المنير

إن أهمّية دور وسائل الإعلام الإجتماعية في نشر الأخبار في تفاقم مستمر، وهذا من شأنه أن يبعث على الإنشغال لأسباب عديدة. أسبن أجيل هانسن من الصحيفة النرويجية اليومية أفتن بوستن ورتشارد آلن من فيسبوك ينتميان إلى عالمين مختلفين، لكنهما يُواجهان نفس التحدّيات.

مارينا يالويان

صورة بالأبيض والأسود لفتاة التسع سنوات، عارية الجسم، تصرخ وهي فارة من القنابل وعلى وجهها علامات ألم شديد. هذه الصورة رمز للتصوير الفوتوغرافي للحروب. التقطها المصور الأمريكي-الفيتنامي نيك أوت سنة 1972 أثناء هجوم بالنابالم على قرية فيتنامية. هذه الصورة التي تحمل أسم «ذي تيرور أوف وار» (الرعب من الحرب) والتي أحرزت على جائزة بوليتزر، خلقت جدلا سنة 2016، عندما استُبعدت من فيسبوك بذريعة أن بها «محتوى غير مناسب».

«كتبت إلى مارك زوكربارغ لأقول له إنني لن أمتثل إلى شروطه»، هذا ما ذكره أسبن أجيل هانسن رئيس تحرير أفتنبوستن وهي أكبر الصحف اليومية النرويجية، الذي تقاسم الصورة على الفيسبوك ووجد نفسه مُهدّدا بالإقصاء النهائي من الشبكة. وفي الردّ العنيف الذي نشره في الصفحة الأولى لصحيفة أفتنبوستن، اتّهم هانسن فيسبوك بوضع قواعد «لا تفرق بين صور الإستغلال الجنسي للأطفال وبين صور الحروب الشهيرة»، هذا من ناحية، ومن ناحية أخرى «فهذه القواعد لا تترك أي مجال» للنقاش. وكانت هذه الرسالة، التي لاقت مساندة مُكثّفة، نقطة الإنطلاق لحوار حماسي حول قواعد الرقابة المُعقّدة لفيسبوك وحول طريقته في مراقبة المحتويات عبر فرز الأحداث بواسطة الخوارزميات.

يَعُدّ فيسبوك اليوم ملياري مُستعمل عبر العالم، ويجذب إلى مواقع وسائل الإعلام أكثر من غوغل، وقد أصبح بذلك فاعلا أساسيا في نشر الخبر، إلاّ أنه مصرّ على عدم الإعتراف بهذه المسؤولية معتبرا أنه مجرد «أرضية تقنية». ومع ذلك، يُمكن القول بأن فيسبوك أصبح أول موقع إعلامي ذي بعد عالمي، وهو ما يجعل من مارك زوكربارغ، كما جاء على لسان هانسن، «أقوى رئيس تحرير في العالم».

«ذكّرت زوكربارغ بأن صفته هذه تلزمه بالإرتباط بمسؤوليات معينة لأن الشركة التي يسيّرها ليست ذات صبغة تقنية بحتة، بل هي مؤسسة إعلامية أيضا». هذا هو السبب الذي جعل أجيل هانسن يعتبر أن منع نشر صورة صحفية رمزية بحجة العراء ما هو إلا قرار سيّء من منظور السياسة التحريرية، مُذكّرا أن «الصور المزعجة قد لا تحظى بالإعجاب، إنّما يبقى لها دور تحسيسي أساسي في مجتمعنا الديمقراطي».

يقوم الملايين بنشر مضامين في الفيسبوك يوميّا، مما يجعل من عملية الإنتقاء حالة بحالة عسيرة جدا. ويدافع رتشارد آلن، نائب رئيس فيسبوك المكلف بالسياسات العمومية لمنطقة أوروبا والشرق الأوسط وإفريقيا، عن النظام الداخلي للشبكة الذي ينص على التبليغ عن أية صورة لطفل عاري الجسم يقلّ عمره عن 18 سنة، ممّا يؤدي إلى سحبها. لكنه يعترف بفشل هذه السياسة في ما يتعلق بصورة «الرعب من الحرب».

وخلال الندوة التي نظّمتها اليونسكو في مارس 2017 تحت عنوان «الصحافة تحت طائل الإنتقادات»، دافع رتشارد آلن عن قدرة فيسبوك على التعديل قائلا: « لنكن واضحين : نحن نراجع أنفسنا باستمرار، وعندما نواجه وضعا غير متوقع، نفكر في الحلول الممكنة وننظر في سبل مراجعة القواعد التي نعمل على أساسها».

ولمزيد من المرونة، اتبع فيسبوك منهجا جديدا يفرض انتداب عدد كبير من الموظفين المكلفين بالتعديل (وقد أعلنت الشركة في ماي 2017 عن اعتزامها انتداب 3000 موظف لتدعيم الفريق الحالي الذي يعدّ 4500) وذلك حتى يتمكن من تخصيص معالجة ملائمة للمقالات المنقولة عن وسائل الإعلام، والتي تُعتبر استثناء بالمقارنة مع ما ينشر عادة في فيسبوك. ويُضيف رتشارد آلن: «إذا كان نشر صورة لطفل عاري الجسد بموافقة المعني بالأمر يخدم المصلحة العامة، فعلينا أن نتجاوز السياسة المتبعة».

الخوارزمية، رئيس التحرير العالمي الجديد

وبما أن الأمر يتعلّق بالإختيارات التحريرية، فإن الفرق بين فيسبوك وفضاءات الإعلام التقليدية ضئيل. ويقول أجيل هانسن في هذا الصدد بلهجة صارمة : «كما أن رئيس تحرير فوكس نيوز هو المسؤول عن المحتوى التحريري لـفوكس نيوز، فإن مارك زوكربارغ هو المسؤول عن المحتوى التحريري لفيسبوك» .

والفرق الحقيقي الوحيد بين الإثنين هو استعمال الخوارزمية في إختيار المضامين، تلك الآلية غير المفهومة بتاتا والمثيرة للجدل : ولا أثر لها في الصحافة التقليدية.

يلح رتشارد آلن قائلا: «يسعى فيسبوك للحفاظ على خصوصيته. فأنت هو الناشر لإنتاجك وأنت من يختار ما تريد مشاهدته». ولكن تبقى الخوارزميات هي التي تكيّف عادات القراءة لدى ما يُقارب مليارا من المستعملين الناشطين على فيسبوك، أي خمس سكان العالم. رسميا، تتمثّل مهمّة هذا الموقع في تفحّص وتحليل المعلومات التي ينشرها المستعمل أو المستعملة خلال الأسبوع المنقضي، أخذا بعين الإعتبار كل الصفحات التي نالت "اللايكات" (الإعجاب)، وكل المجموعات التي انخرط أو انخرطت فيها، وكل شخص يقوم أو تقوم بمتابعته. بعد ذلك، وحسب صيغة سرية يتمّ تجديدها باستمرار، ترتّب الخوارزميات التدوينات المنشورة حسب النظام الذي يتوافق مع اهتمامات المستعمل.

إلّا أن الخوارزميات، بحكم طبيعتها الأصلية، قد تصبح أداة تُثير إشكاليات إن لم نقل أداة خطيرة. ويُفسّر أجيل هانسن ذلك بالقول بأن «تفعيل الخوارزميات يؤدي إلى انتقاء معايير محدّدة وحشرها في ما يسمى بفقاعات التصفية، وذلك من شأنه أن يعزز تلك الظاهرة السلبية وليدة عصرنا، ألا وهي تكوين تجمعات مستقطبة». ويضيف أجيل هانسن: «إن عدد مستعملي الفيسبوك المسجونين في تلك الفقاعات يزداد يوما بعد يوم، لا يحصلون إلا على الخبر الذي يرغبون فيه ولا يتواصلون إلا مع الأشخاص الذين يتقاسمون معهم نفس الآراء». ومن هذا المنظور، تصبح معايير الإنتقاء المُحددة بالخوارزمية لتصنيف الأخبار حسب الأولوية، أمرا حاسما.

من جهته، يقارن رتشارد آلن متابعة شريط تسلسل الأحداث في الفيسبوك بالإنخراط في دورية إعلامية، ولا يعترف بأن فيسبوك يفرض على قرّائه محتوى مُعيّنا. فالخوارزمية، حسب رأيه، لا يتجاوز دورها ترتيب العناوين للقراء بما فيه أكثر أريحية. لكن التحدّي يكمن في الكمية الهائلة للمدّ المتوفّر. ويقول رتشارد آلن: «الملاحظ هو أن المستعملين يشتركون في حوالي ألف مدّ مختلف، في حين لا يسمح لهم وقتهم بقراءة أكثر من عشرين»، ويضيف: «الإمدادات الألف تبقى دائما متوفرة، لكن ذلك يؤدي بنا حتما إلى عملية الإنتقاء بما أننا نحتفظ بتلك التي تطفو في أعلى الكومة».

إن تيسير الأخبار المُفضلة للقراء يمكن أن يجرّ إلى ما لا تحمد عقباه. وحسب ما ذهب إليه أجيل هانسن، فإن «مثل تلك الإستراتيجية لها مزاياها عندما يتعلق الأمر بمشاهدة "ناتفليكس" (موقع يوفر الأفلام بصفة مستمرة مقرّه في الولايات المتحدة)» لكنها تبقى «مبدأ قابلا للنقاش في ما يخص حرية انتشار الخبر صلب مجتمع ما».

دور الحكم في مواجهة الحقيقة

وحتى نكون أكثر إيجابية، لنعترف أن وسائل الإعلام الإجتماعية تحطّم الحواجز وتُيسّر التعبير لكلّ منّا. يلاحظ الصّحافي النرويجي، الذي يُتابع صحيفته على فيسبوك 340.000 شخص: «عندما كتبت لمارك زوكربارغ، لم تكن رسالتي إلا مقالا صغيرا صدر في بلاد صغيرة، لكن محتواه انتشر بسرعة البرق في كل مكان. ومن المفارقات أن يكون فيسبوك هو بالذات صاحب الفضل في هذا الإنتشار». لكن سرعان ما يعترف أجيل هانسن أن الإمكانية المُتاحة للجميع لنشر الأخبار هي سيف ذو حدّين يمكن أن يُؤدّي إلى التضليل، وينبّه : «لقد أصبحت اليوم مغالطة مجتمعات بأسرها من السهولة بمكان. وأتساءل إن كنا، كمجتمع، مستعدين حقا لمثل هذا المستقبل الباعث على القلق».

في إطار سلسلة الفضائح المتعلقة بالأخبار الزائفة التي هزّت فيسبوك سنة 2016، اتُّهمت الشركة بالتأثير على الإنتخابات الرئاسية الأمريكية من خلال نشر أخبار كاذبة وبخلق فقاعات تصفية تمنع الناخبين من الحصول على آراء غير مُطابقة لآرائهم. وحسب أحد التحاليل، إذا أخذنا بعين الإعتبار الأخبار المتصلة بالسياسة الأمريكية فقط، فإنّ الأخبار الزائفة استأثرت بـ 10،6 مليون من بين 21،5 مليون من التوزيعات وردود الفعل والتعاليق التي أثارتها المقالات باللغة الإنجليزية في تلك السنة. أما الخبر الكاذب (الخدعة) المتعلق بباراك أوباما، الرئيس السابق للولايات المتحدة، فقد نتج عنه أكثر من 2،1 مليون تعليق وردود فعل وتوزيع على فيسبوك خلال شهرين فقط.

وحتى يُخمد الإنتقادات، ليس من الغريب أن يقرر فيسبوك وضع برنامج للتثبّت في الأحداث بهدف إصلاح منظومته : فبداية من مايو 2017، تكون المقالات المُبلّغ عن عدم الوثوق بها من قبل المستعملين محلّ تدقيق من طرف خبراء، ويتمّ إدراجها في صنف «محتوى مُعترض عليه». ويُوضّح رتشارد آلن في هذا الصدد: «لن نقوم بحذف هذه المحتويات. ذلك أننا من ناحية لا نريد لعب دور الحكم في مواجهة الحقيقة، ومن الأخرى فإننا نسعى إلى بناء مجموعة مطّلعة باعتبارنا مسؤولين أمام مجتمعنا».

ويتقبّل أجيل هانسن هذا الإعتراف على أنه أساسي، ويُعبّر عن ارتياحه للتحسينات الإيجابية المُقدّمة من طرف فيسبوك منذ الإنتشار الهائل الذي لاقته رسالته الأولى (المنشورة في صحيفة أفتنبوستن)، مُوضّحا : «لقد خصّ مارك زوكربارغ صحيفة نيويورك تايمز بحديث بيّن فيه أن الجدال الذي أثارته تلك الرسالة فتح بصيرته وجعله يعي بضرورة تغيير طريقة تشغيل فيسبوك».

كان ذلك وعيا مصحوبا بتدابير تبدو حاسمة، بالنظر إلى التأثير الهائل لوسائط الإعلام الإجتماعية على وسائل الإعلام التقليدية والتزايد المستمر لحضورها العارم في حياتنا اليومية.

رسالة مفتوحة بمثابة الصدمة الكهربائية

« (...) اسمع يا مارك، الأمر خطير ! في البداية، وضعتَ قواعد لا تُفرّق بتاتا بين صور إباحية للأطفال وصور شهيرة للحروب، ثمّ أخذت في تطبيقها دون أن تترك أي مجال للتفكير. وفي الأخير، فأنت لا تتوارى عن حجب الإنتقاد والحوار الدائر حول قرارك هذا، وتعاقب الشخص الذي تجرّأ على الوقوف ضدّه (...)

إن وسائل الإعلام الحرّة والمستقلّة تلعب دورا هامّا في نشر المعلومات، بما فيها الصور، التي قد تكون مُزعجة أحيانا، تلك المعلومات التي لا تريد النخبة، وأحيانا المواطنون البسطاء، مشاهدتها أو سماعها، لكنها قد تكون هامّة لذلك السبب بالذات (...).

كما أن لوسائل الإعلام مسؤولية التفكير في ما تنشره حالة بحالة. وهي مسؤولية ثقيلة أحيانا. فعلى كل محرر أن يقيّم الإيجابيات والسلبيات. هذا الحق وهذا الواجب اللذان يحظى بهما كافة الصحفيين في العالم، يجب ألّا يكونا عُرضة للتقويض من قبل خوارزميات تمّ تشفيرها في مكتبك بكاليفرنيا.

لقد منح فيسبوك لنفسه رسميا مهمّة «جعل العالم أكثر انفتاحا وتواصلا». وفي الواقع، فإنك تؤدّي هذه المهمة بشكل سطحي تام. وإذا كنت ترغب في عدم التفريق بين صور إباحية للأطفال وصور توثيقية أُخذت أثناء الصراعات، فإن ذلك لا يُمكن إلّا أن يُشجّع على الغباء ولن يُساهم البتّة في التقريب بين الناس.

إن ادعاء إمكانية خلق قواعد مُشتركة وكونية حول ما يمكن نشره وما لا يُمكن، إنما هو ذرّ الرماد على الأعين، لا غير (...) ».

(مقتطف من الرسالة المفتوحة التي وجّهها أسبن أجيل هانسن إلى مارك زوكربارغ والتي نُشرت في الصفحة الأولى من أفتنبوستن بتاريخ 8 سبتمبر 2016).

[VIDEO::https://youtu.be/SpQjvM-t19U?list=PLWuYED1WVJIMR0LCfRDgbRHRWEtocdxKJ]

[VIDEO::https://youtu.be/gyhEZSmp_2Q?list=PLWuYED1WVJIMR0LCfRDgbRHRWEtocdxKJ]

By Marina Yaloyan

It is an icon of war photography: the black-and-white image reveals a naked nine-year-old girl, fleeing from an explosion, screaming, her face distorted with pain. Taken by Vietnamese-American photographer, Nick Ut, during the napalm strike on a Vietnamese village in 1972, the Pulitzer prize-winning photo, “The Terror of War”, raised controversy in 2016, when Facebook banned it because of “inappropriate content”.

“I wrote to Mark Zuckerberg telling him that I wouldn’t comply,” remembers Espen Egil Hansen, the editor-in-chief of Aftenposten, Norway’s largest newspaper, who shared the post on Facebook and got threatened with a permanent ban. Hansen’s bold letter, splashed across the front page of Aftenposten, condemned Facebook for creating rules that first “cannot distinguish between child pornography and famous war photographs” and then “exclude every possible debate.” The letter drew massive support and became the starting point for a heated discussion around Facebook’s intricate censorship rules and the control of content through newsfeed algorithms.

With two billion users worldwide and leading more traffic to news sites than Google, Facebook has now emerged as a major player in news distribution, even though it still evades formal responsibility by positioning itself as a “technical platform”. Nevertheless, it has arguably become the largest global media site, which has turned Mark Zuckerberg into “the most powerful editor-in-chief in the world,” according to Hansen.

“I reminded Zuckerberg that this title comes with responsibility. He doesn’t just own a tech company, he owns a media company.” This is precisely why Hansen considers that censoring an iconic image of photojournalism because of nudity was a bad editorial decision. “Disturbing images may not always be comfortable to look at, but they are the ones that help promote awareness in a democratic society,” he says.

Millions of people post content on Facebook’s pages every day, which makes the process of selecting information case-by-case an obvious challenge. Richard Allan, Facebook’s Vice President, Public Policy, EMEA (Europe, the Middle East and Africa), defends the site’s general guidelines, which demand that photographs of children under 18 containing nudity are tracked and taken down. Yet, he does admit that with the “The Terror of War” photo, this policy fell short. “Just to be clear, we question ourselves all the time. When we face a new situation we haven’t anticipated before, we ask ourselves, what should we do now? Should we change our rules?” he stated during the colloquium, Journalism under Fire, at UNESCO in March 2017.

Two months later, Facebook announced that it would add 3,000 more people to its 4,500-strong community operations team. The newly-adopted, more flexible, approach requires content reviewers to treat news as an exception. “There are occasional photos of naked children where the public interest of the publication of that photo and, in this case, the consent of the person involved, outweighs the regular policy,” Allan says.

Algorithm – the world’s new editor-in-chief

There is little or no significant difference between Facebook and traditional news venues when it comes to editorial choice. “In the same way in which an editor-in-chief of Fox News is responsible for the editorial content of Fox News, Mark Zuckerberg is responsible for the editorial content of Facebook,” insists Hansen.

The only real difference between the two is the largely misunderstood and controversial newsfeed algorithm that traditional media editors do not use. “We want to keep our essence. You are your own editor and you choose what you want to see,” states Richard Allan, regarding Facebook’s policy.

Meanwhile, algorithms continue to shape the reading habits of 1.28 billion daily active Facebook users (March 2017), or one-fifth of the world’s population. Facebook scans and analyzes all the information posted by any given user in the previous week, taking into account every page that he or she has liked, all the groups he/she belongs to and everybody he/she follows. Then, according to a closely-guarded and constantly evolving formula, the algorithms rank the posts in the precise order they believe the user will find worthwhile.

However, the very nature of algorithms can turn them into controversial, and even dangerous, tools. “Algorithms may create the so-called filter bubbles, which reinforce a negative trend of our time – one that leads to more polarized communities,” says Hansen. “More and more people live in bubbles, where they only get the information they want, and communicate only with like-minded people.” From this perspective, the criteria of selection used by algorithms to classify information become crucially important.

Allan, however, compares the newsfeed to a periodical subscription and denies imposing any content on Facebook’s readers. According to him, algorithms merely allow for the arranging of periodicals in a way that is most convenient for the reader. The challenge, however, lies in the large quantity of newsfeeds available. “What we find is that people sign up for a thousand different feeds when they only have time to read twenty of them,” he says. “The thousand feeds are still there but this obviously creates a selection process, as we pick those that are going to appear on the top.”

Favouring the information that readers prefer can be a slippery road. According to Hansen, it is a “convenient strategy when watching Netflix [the United States-based streaming service]” but remains a “questionable principle for the free flow of information in a society.”

Fake news – real solutions?

On a positive note, social media sites do breach barriers and make it easier for people to express themselves. “When I wrote my letter to Mark Zuckerberg, I published it in a small paper in a small country, but the story immediately went viral. Ironically, I think it was Facebook itself that made the story so popular,” recalls Hansen, whose own newspaper has more than 340, 000 followers on Facebook. However, he quickly admits that the opportunity given to everyone to publish information is a double-edged sword that may lead to disinformation. “It is obviously easier today to mislead very large parts of populations. I wonder if, as a society, we are actually prepared for the alarming trends that we are witnessing,” he says.

In a series of scandals related to fake news that shook Facebook in 2016, the company has been accused of influencing the United States Presidential election, by spreading fake news stories and creating filter bubbles that isolated voters from other opinions. Overall, fake news about US politics alone accounted for 10.6 million of the 21.5 million total shares, reactions, and comments these English-language stories generated on Facebook this year, according to one analysis. A hoax about former US President Barack Obama generated more than 2.1 million comments, reactions and shares on Facebook in just two months.

No wonder that in order to curb criticism, Facebook has introduced a corrective fact-checking programme. Starting in May 2017, stories that have been signalled by users as unreliable are verified by independent fact-checking experts and labelled as “disputed”.

“We are not going to remove these,” stresses Richard Allan. “On one hand, we don’t want to be the arbiters of truth and edit content. On the other, we would like to build an informed community, as we have a responsibility to society.”

Hansen views the acknowledgement of this responsibility as key. He praises the positive improvements that Facebook has adopted since his letter in Aftenposten first came into the spotlight. “Mark Zuckerberg gave an interview to the New York Times, where he said that the controversy around this letter was an eye-opener and made him realize that he needed to change the way Facebook functions.”

This realization and subsequent change become crucial, especially in the wake of social media’s broad impact on traditional media and its ever-growing omnipresence in our daily lives.